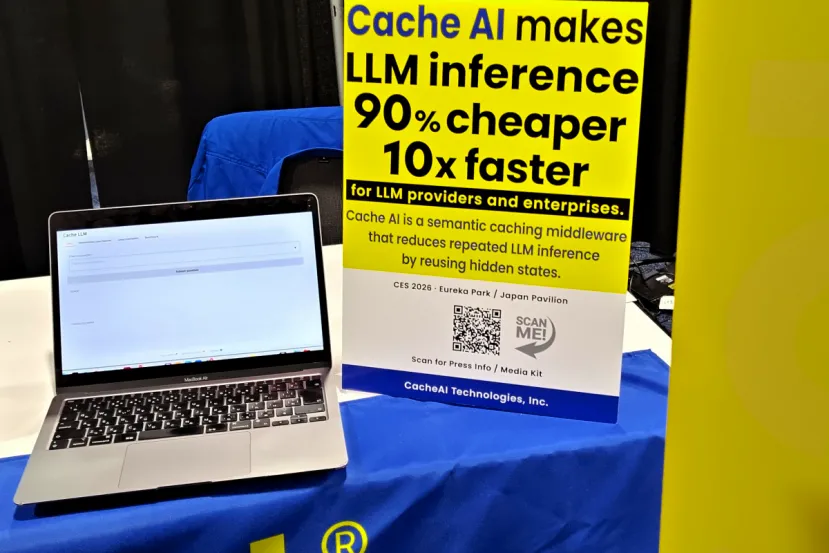

Cache AI promete reducir un 90% los costes de la IA evitando que los modelos piensen dos veces lo mismo

por Edgar Otero CES 2026No todo van a ser robots con IA y gafas de realidad aumentada. En el CES 2026 también hay espacio para el software. Uno de los grandes problemas técnicos que enfrentan las empresas al escalar el uso de la inteligencia artificial es el coste computacional y la latencia. En ese contexto, se ha presentado Cache AI, una herramienta de software diseñada para atacar directamente este cuello de botella. Su propuesta se basa en eliminar el cálculo redundante en los LLM, permitiendo reutilizar estados internos para evitar que el hardware trabaje innecesariamente en consultas repetidas.

El funcionamiento se basa en la lógica de "misma consulta, diferente coste". Cuando un usuario realiza una pregunta a un modelo por primera vez, el proceso puede tardar, por ejemplo, unos 7,2 segundos en generar la respuesta mientras se almacena el resultado. La novedad radica en que, si se realiza una pregunta semánticamente similar, el sistema recupera la respuesta en apenas 0,0022 segundos. Esto se logra entregando el dato desde la memoria caché, sin necesidad de realizar una nueva llamada a la GPU.

Una capa intermedia que no exige modificar los modelos actuales

Desde el punto de vista de la arquitectura, Cache AI funciona como un middleware de producción. Se despliega dentro del entorno del cliente, situándose justo entre las aplicaciones y la pila de inferencia del LLM. El software intercepta las solicitudes entrantes y realiza una búsqueda semántica utilizando representaciones intermedias. Si encuentra una coincidencia, devuelve la respuesta guardada; si no, deja pasar la solicitud al modelo sin alterarla.

Una de las ventajas clave para su adopción es que no requiere modificar los modelos, los prompts ni la lógica de inferencia existente, manteniendo los límites de responsabilidad operativa. Según los datos proporcionados, esta técnica puede lograr una inferencia hasta 10 veces más rápida en los aciertos de caché y reducir los costes de GPU hasta en un 90%, siendo especialmente útil en flujos de trabajo de soporte y agentes virtuales.

Fin del Artículo. ¡Cuéntanos algo en los Comentarios!